ในยุคที่ AI กำลังเข้ามามีบทบาทในทุกมิติของธุรกิจ ตั้งแต่การบริการลูกค้า การวิเคราะห์ข้อมูล ไปจนถึงการสร้างประสบการณ์ใหม่ ๆ ให้กับผู้ใช้งาน สิ่งหนึ่งที่หลายองค์กรเริ่มตระหนักคือ “เราพร้อมแค่ไหนที่จะเชื่อม AI เข้ากับระบบของเรา?”

การทำแอปต่อกับ API ของผู้ให้บริการไม่ใช้เรื่องยาก แต่การทำให้มันพร้อมใช้งานจริง ๆ ในระดับองค์กร มีการคำนึงถึงประสิทธิภาพ การจัดการที่ดี มีความปลอดภัยนี่สิครับ ไม่ใช่เรื่องง่าย แต่วันนี้ผมจะขอพาทุกคนมารู้จักกับบริการที่จะทำให้เราสามารถทำแอปต่อกับ AI ได้อย่างมีประสิทธิภาพ ปลอดภัยและมีมาตรฐานไปกับ Kong AI Gateway แต่ก่อนอื่น เรามารู้จักกับ Kong กันแบบไว ๆ ก่อนครับ

แล้ว Kong คืออะไร?

Kong คือแพลตฟอร์มที่ทำหน้าที่เป็น API Gateway แบบ Cloud-Native หรือพูดง่าย ๆ คือ “ด่านหน้าของระบบ” ที่ช่วยให้บริการต่าง ๆ เชื่อมต่อกันได้อย่างมีประสิทธิภาพ ปลอดภัย และควบคุมได้ ซึ่งเรียกได้ว่าวงการการพัฒนาซอร์ฟแวร์การเอา Kong มาใช้เป็นเรื่องปกติของการทำซอร์ฟแวร์สมัยใหม่กันอยู่แล้ว

เพราะ Kong ถูกออกแบบมาให้มีความเบา ทำงานได้เร็ว และมีความยืดหยุ่น เหมาะกับทั้งองค์กรขนาดเล็กที่ต้องการเริ่มต้น และองค์กรขนาดใหญ่ที่ต้องการระบบที่รองรับทราฟฟิกสูงและต้องการควบคุมอย่างละเอียด

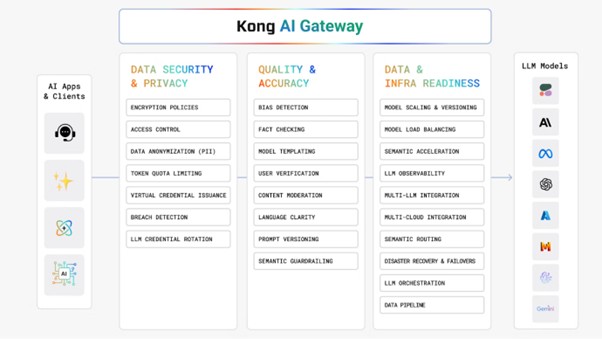

Kong AI Gateway

ภาพจาก : https://konghq.com/blog/engineering/rag-application-kong-ai-gateway-3-8

แต่ Kong AI Gateway จะเป็นอีกบริการหนึ่งของ Kong ที่เอามาเสริมทัพในเทรนด์ของ AI โดยเป็นบริการ “ตัวกลางอัจฉริยะ” ที่อยู่ระหว่างผู้ใช้งาน (Client) กับระบบหลังบ้าน

จุดเด่นของ Kong AI Gateway คือ ทำให้เราจัดการกับ API ที่ต้องมีการต่อกับ AI ได้ง่ายยิ่งขึ้น ช่วยในการเชื่อมต่อระบบของเรากับบริการ AI โดยไม่ต้องสร้างระบบใหม่

รองรับการการใช้งานทั้งแบบเขียนโค้ด และ ไม่ต้องเขียนโค้ด (No-Code Integration) เราสามารถ Config ให้ API ส่งข้อมูลไปยัง AI Service ได้อย่างปลอดภัย แถมยังทำงานได้ทั้งบนคลาวด์และไฮบริด ไม่ว่าระบบของเราจะอยู่ในองค์กร (On-prem) หรือ บนคลาวด์ Kong ก็สามารถติดตั้งและทำงานร่วมกันได้อย่างราบรื่น

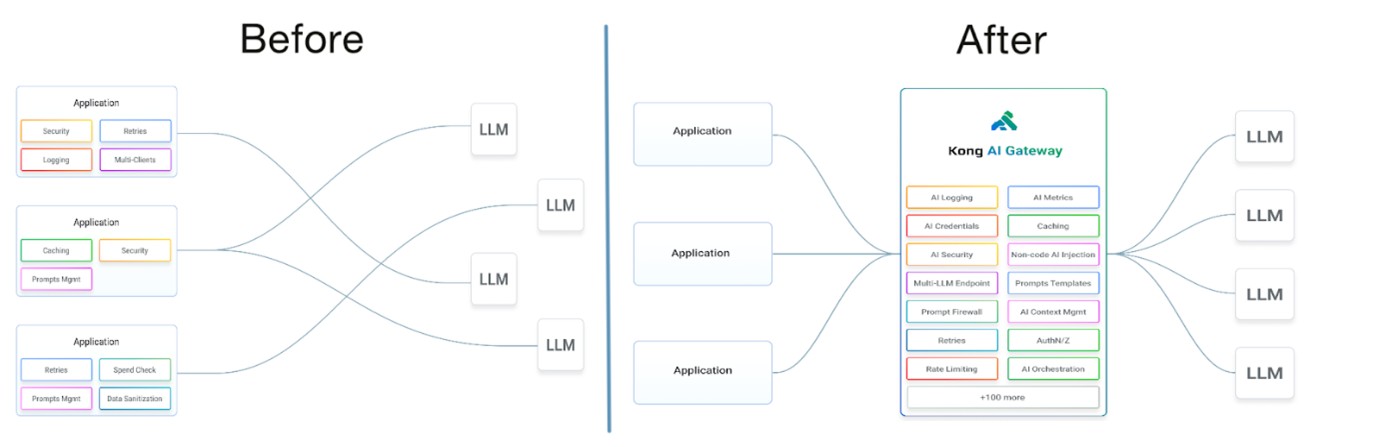

Kong AI Gateway ทำงานอย่างไร?

ภาพจาก : https://docs.konghq.com/gateway/latest/ai-gateway/

- เมื่อผู้ใช้งานส่ง Request มา Kong จะเป็นด่านแรกที่รับ Request นั้น

- มันจะตรวจสอบความถูกต้อง ปลอดภัย และตัดสินใจว่าจะส่ง Request ไปที่ AI หรือบริการอื่น ๆ ตามเงื่อนไขที่กำหนดไว้

- Kong จะส่งข้อมูลไปยังโมเดล AI ที่เราเลือกไว้ เช่น GPT-4

- เมื่อได้ผลลัพธ์กลับมา มันก็จะจัดการตอบกลับให้ผู้ใช้งานอย่างเหมาะสม

โดยหากเราใช้ Kong AI Gateway แล้วการใช้งาน AI จากทุก ๆ ผู้ให้บริการจะต้องผ่าน Kong AI Gateway ทำให้แทนที่เราจะต้องไปสมัคร API ของแต่ละเจ้า ไม่ว่าจะเป็น OpenAI, Claude, Mistral หรือ Hugging Face แล้วมาเขียนโค้ดแยก ไล่เชื่อมต่อทีละตัว เขียนเชื่อมต่อแล้วต้องมานั่งจัดการ Key ของแต่ละเจ้า ปรับโครงสร้างของระบบให้รองรับอีก ซึ่งแต่ละ API ก็ไม่เหมือนกัน การใช้ Kong AI Gateway จะลดปัญหาตรงนี้ไปได้เยอะ

เชื่อมทีเดียว ใช้ได้หลายเจ้า

จากเนื้อหาด้านบนเราจะเห็นได้ว่า Kong AI Gateway ทำหน้าที่เป็นเหมือน “หัวรวม” ที่ให้เราเชื่อมต่อกับมันแค่ครั้งเดียว จากนั้นเราก็สามารถสลับไปใช้โมเดล AI เจ้าไหนก็ได้ โดยไม่ต้องแก้โค้ดเดิมเลยแม้แต่นิดเดียว วันนี้อยากลอง GPT-4 พรุ่งนี้เปลี่ยนไปใช้ Claude ก็แค่ปรับค่าบน Kong ได้เลย

ใช้ AI ได้แบบไม่ต้องเขียนโค้ด

ถ้าเรารู้สึกว่า AI เป็นเรื่องที่ดูห่างไกล เพราะต้องมีโค้ดเยอะ ต้องเข้าใจเรื่องพารามิเตอร์ ต้องเรียนรู้วิธีเชื่อม API Kong กำลังเข้ามาเปลี่ยนเกมนี้ให้เราครับ

ด้วยฟีเจอร์ No-Code Integration เราแค่เลือกว่า API ตัวไหนในระบบของเราจะส่งต่อไปยัง AI ตั้งค่า Prompt หรือพารามิเตอร์อื่น ๆ เช่น Max Tokens แล้วก็กดบันทึก แค่นั้นเลยจริง ๆ ไม่ต้องเขียนโค้ด ไม่ต้องรอทีม Dev มาช่วย Kong AI Gateway ช่วยตัดปัญหาทั้งหมดนี้ให้เราแบบเบ็ดเสร็จ

เริ่มต้นใช้งานง่าย ไม่ยุ่งยาก

เราสามารถใช้งาน Kong AI Gateway ได้ทั้งแบบ GUI และ YAML เรียกได้ว่าทีมไหนสะดวกแบบ No Code หรือสายจัดการผ่าน GitOps ก็สามารถใช้งานได้แบบเต็มที่

เดี๋ยวเรามาดูตัวอย่างการใช้งานจริง ๆ ผ่านระบ RAG ที่ต้องทำระบบให้ AI ไปอ่านข้อมูลจากองค์กรของเรากันเลยดีกว่าครับ

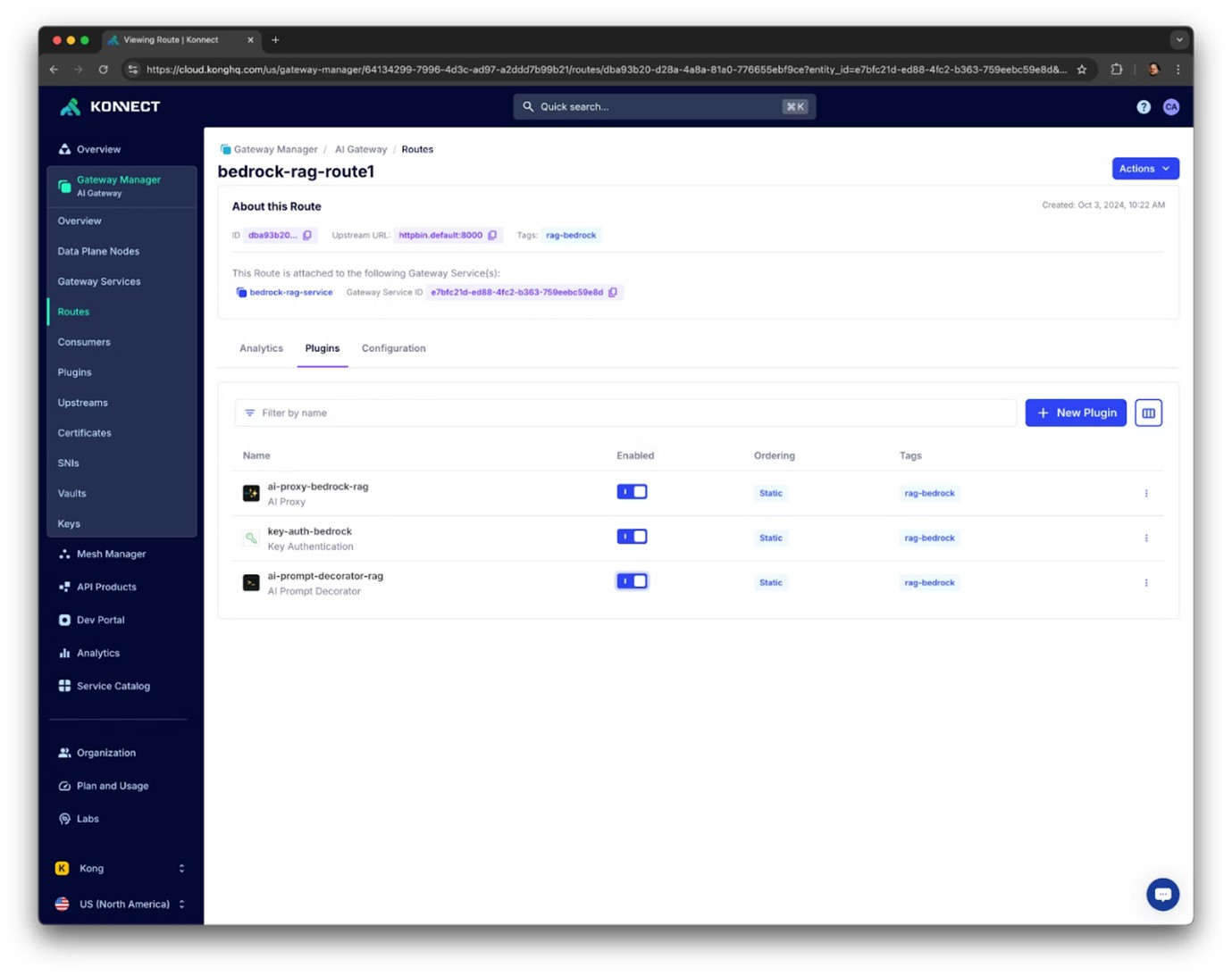

ตัวอย่างการใช้ Kong AI Gateway ผ่าน GUI

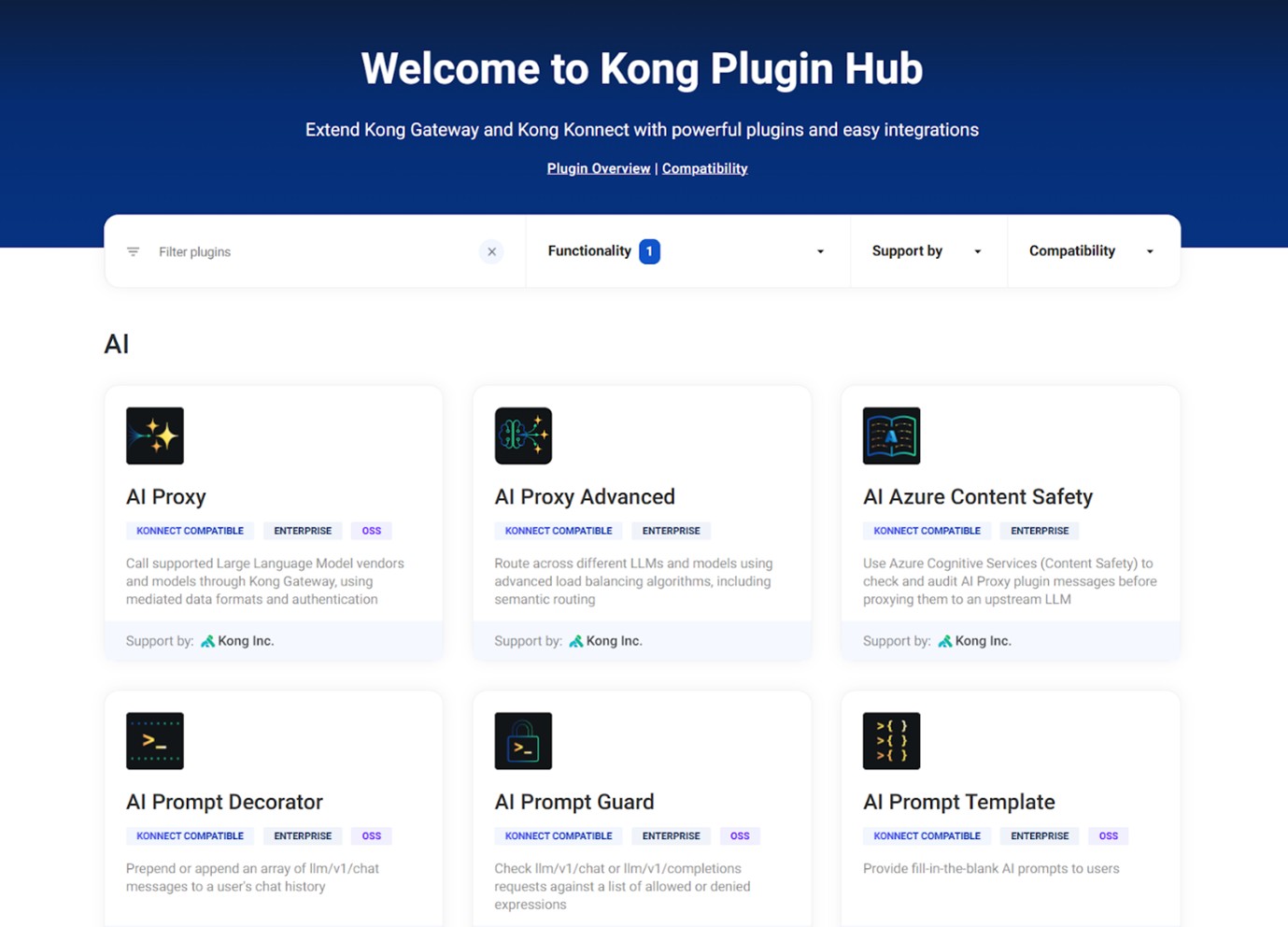

ภาพจาก : https://konghq.com/blog/engineering/rag-application-kong-ai-gateway-3-8

โดยตัวอย่างภาพตัวอย่างนี้เป็น การใช้งาน Kong AI Gateway แบบ GUI ผ่าน Kong Konnect มีการ Route สำหรับ AI Traffic ผ่านหน้า GUI นี้ได้เลย ไม่จำเป็นต้องเขียนโค้ดหรือใช้ CLI เลย ในภาพเราจะเห็นอีกว่าได้ว่ามีการ สร้าง Route ที่จะใช้รับ AI Request เช่น bedrock-rag-route1 ซึ่งเชื่อมโยงกับ Service ภายในที่ใช้เชื่อมต่อกับ LLM provider (เช่น AWS Bedrock)

ติดตั้ง Plugin ที่เกี่ยวข้องกับ AI อันนี้แหละเป็นจุดที่ชูโรงของ Kong AI Gateway เลยครับ เพราะเค้ามี Plugin ที่พร้อมมาสำหรับงานแอปต่อกับ AI มาแล้ว อย่างในภาพจะเป็นการใช้ AI Proxy เพื่อใช้กำหนดว่า traffic นี้จะถูกส่งไปยัง LLM โมเดลไหน เช่น OpenAI, Anthropic, Claude หรือ Titan ผ่าน Bedrock

ปลั๊กอินตัวต่อมาที่เห็นคือ Key Authentication ตัวนี้เอาไว้บังคับให้มีการส่ง API key ก่อนอนุญาตให้ใช้งาน เพื่อป้องกันใครก็ไม่รู้เอา API ของเราไปใช้งานหรือจะเป็นปลั๊กอินอย่าง AI Prompt Decorator ช่วยเพิ่มหรือแทรก system prompt เข้าไปในคำสั่งผู้ใช้โดยอัตโนมัติ เช่นใช้ใน Retrieval-Augmented Generation (RAG) ด้วยความสามารถแบบนี้ Kong Konnect จึงเหมาะอย่างยิ่งสำหรับทีมที่ต้องการ เชื่อมต่อและจัดการ AI/LLM traffic แบบ production-grade โดยไม่ต้องสร้างระบบเองตั้งแต่ต้น ทั้งยังสามารถรองรับงานที่ต้องการ Observability, Security, และ Prompt Engineering ได้ครบจบในจุดเดียว

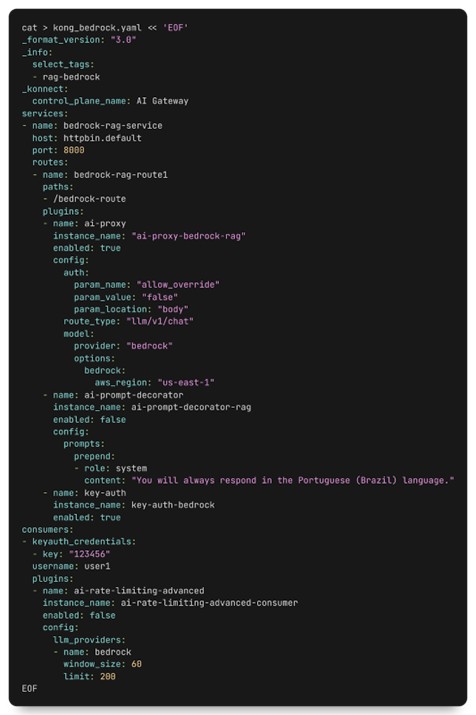

ตัวอย่างการใช้ Kong AI Gateway ผ่าน YAML

ส่วนหากใครเป็นสาย Dev หรือสาย Infra ที่คุ้นเคยกับ YAML เราสามารถใช้ไฟล์ YAML ในการจัดการ Kong AI Gateway แบบ declarative ได้อย่างเต็มรูปแบบผ่านเครื่องมือที่ชื่อว่า decK เป็นวิธีที่เหมาะสำหรับทีมที่ใช้ GitOps, CI/CD, หรือ Infrastructure as Code (IaC) โดยเราสามารถกำหนดทุกอย่างตั้งแต่ Service, Route, Plugin ไปจนถึง Consumer และ Policy ได้ในไฟล์เดียว

จากภาพตัวอย่างด้านบนเป็นไฟล์ YAML ที่ตั้งค่าทั้งหมดแบบเดียวกันเลยกับหน้าจอ GUI ก่อนหน้านี้

เราพูดถึงปลั๊กอินกันไปแล้ว เดี๋ยวผมขอเล่าเพิ่มหน่อยเกี่ยวกับปลั๊กอินที่เรียกเรียกใช้ได้เลยบน Kong AI Gateway ต้องบอกว่ามันทำให้เราสามารถเอามาสร้าง Solution ที่ตอบโจทย์แต่ละบริบทของผู้ใช้ได้อย่างดีจริง ๆ

ภาพจาก : https://docs.konghq.com/hub/?category=ai

โดยตัวแรกก AI Prompt Guard เป็นตัวตรวจสอบข้อความที่ส่งไปยังโมเดล AI แบบ Rule Allow/Deny เรียกง่าย ๆ ว่าเป็นการดักคำ ดัก keyword ที่ไม่เหมาะสม เราสามารถตั้งค่าเป็น regular expression เพื่อป้องกันคำถามที่ไม่เหมาะสมได้

ต่อมาเป็นตัวที่ทำหน้าที่ได้แอดวานซ์มากกว่าอย่าง AI Semantic Prompt Guard ที่เป็นการขยายความสามารถของ Prompt Guard ด้วยการตรวจสอบไปที่ “ความหมาย” ของ prompt เลย ทำให้สามารถบล็อกคำถามที่มีเนื้อหาคล้ายกันแต่เขียนต่างกันได้

หรือจะเป็น AI Prompt Template ที่ให้ผู้ดูแลระบบสามารถสร้างเทมเพลต prompt ที่มีช่องว่างให้ผู้ใช้กรอกข้อมูล ช่วยลดความเสี่ยงจากการใส่ข้อความอันตรายได้ รวมไปถึงปลั๊กอินอื่น ๆ ที่ใช้เพิ่มข้อความอัตโนมัติที่ต้นหรือท้ายบทสนทนา เพื่อควบคุมทิศทางและบริบทของการสนทนาอย่าง AI Prompt Decorator เป็นต้น

ยังไม่ได้หมดแค่นี้นะครับ สามารถลองเลือกดูปลั๊กอินอื่น ๆ อีกเพียบได้ที่ https://docs.konghq.com/hub/?category=ai

ซึ่งปลั๊กอินเหล่านี้เป็นหนึ่งในฟีเจอร์ของ Kong AI Gateway อย่าง AI Observability และ AI Usage Governance ที่ทำมาเพื่อให้ ให้ใช้งาน AI ได้อย่างมีประสิทธิภาพและปลอดภัย

AI Observability และ AI Usage Governance

ซึ่งความสำคัญของสองฟีเจอร์นี้ก็เพราะ การที่ผู้ใช้ส่งคำถามไปยัง AI ในแต่ละคำร้อง (request) จะใช้จำนวน token ไม่เท่ากัน และปริมาณ token ที่ใช้ในแต่ละครั้งมีผลโดยตรงต่อ ค่าใช้จ่าย ที่องค์กรต้องรับผิดชอบ

AI Observability

การมีระบบ AI Observability เข้ามาช่วย จะทำให้เรามองเห็นข้อมูลสำคัญต่าง ๆ ได้อย่างชัดเจน เช่น จำนวน request ที่ส่งไปยังโมเดล AI, ปริมาณ token ที่ใช้, ค่าใช้จ่ายต่อคำร้อง รวมถึงประสิทธิภาพของผู้ให้บริการ AI แต่ละราย

ทั้งหมดนี้สามารถตรวจสอบได้ผ่านระบบ Log, Prometheus, Grafana และ Konnect Advanced Analytic ช่วยให้ทั้งทีม DevOps และผู้บริหารสามารถวางแผนการใช้งาน ปรับปรุงประสิทธิภาพ และควบคุมต้นทุน AI ได้อย่างแม่นยำ

AI Usage Governance

ส่วน AI Usage Governance จะเป็นฟีเจอร์ที่ช่วยควบคุมและบริหารการใช้งาน AI อย่างมีระเบียบและปลอดภัย

เนื่องจากในการส่งคำถามไปยัง AI บางครั้งอาจมีข้อมูลที่อ่อนไหว หรือคำสั่งที่ไม่เหมาะสม ซึ่งอาจนำไปสู่ความเสี่ยงด้านความปลอดภัย หรือการใช้งานที่เกินความจำเป็นโดยไม่รู้ตัว

AI Usage Governance จะเข้ามาช่วยลดความเสี่ยงเหล่านี้ ด้วยเครื่องมือต่าง ๆ ที่เป็นปลั๊กอินที่เราได้พูดถึงเป็นในตอนต้นอย่าง การตั้งค่า Allow/Deny Prompt เพื่อกรองคำถามที่ไม่เหมาะสมหรือสุ่มเสี่ยง ก่อนที่คำขอนั้นจะถูกส่งไปยังโมเดล AI

การใช้งาน Semantic Prompt Guard ที่วิเคราะห์ความหมายของข้อความ แทนที่จะดูแค่คำตรง ๆ ช่วยให้สามารถบล็อกคำถามอันตรายที่ถูกเขียนในรูปแบบใหม่ได้อย่างแม่นยำ

ฟีเจอร์ Rate Limiting ที่ช่วยจำกัดปริมาณการใช้งาน AI ตามต้นทุนของ token ที่ใช้ ช่วยป้องกันการใช้ทรัพยากรเกินจำเป็น และควบคุมค่าใช้จ่ายได้อย่างชัดเจน

ทั้งหมดนี้ช่วยให้การใช้งาน AI ภายในองค์กรเป็นไปอย่างปลอดภัย มีประสิทธิภาพ และสามารถควบคุมได้อย่างโปร่งใส

Real-World Use Case: Building a RAG Application with Kong AI Gateway, Amazon Bedrock, Redis, and LangChain

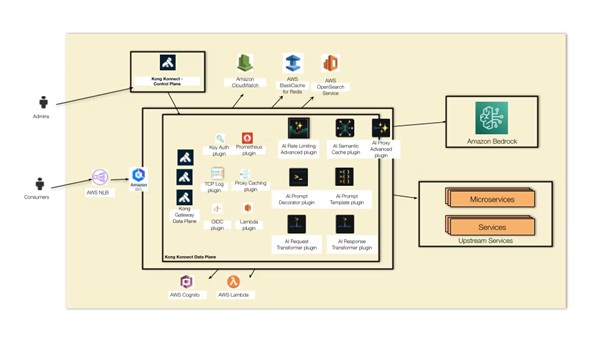

ภาพจาก : https://konghq.com/blog/engineering/rag-application-kong-ai-gateway-3-8

จากที่เราได้รู้จักกับ Kong AI Gateway เบื้องต้นกันไปแล้ว คราวนี้…ลองมาดูเคสจริงกันครับว่า “เขาเอา Kong AI Gateway ไปทำอะไร?” และที่สำคัญ มันช่วยให้การใช้ AI ในองค์กรง่ายขึ้นแค่ไหน

โดยตัวอย่างคือทีม Kong ได้มีการใช้ Kong AI Gateway + LangChain + AWS Bedrock ทำระบบ RAG (Retrieval Augmented Generation) ที่ทำให้สามารถเอา LLM ที่เป็นสมองของ AI มาต่อกับข้อมูลภายในมากมาย ทั้งเอกสาร คู่มือการใช้งานระบบ ไฟล์ Word หรือ PDF ที่กระจัดกระจายเต็มไป ดึงข้อมูลเหล่านี้มาเป็นบริบทที่ถูกต้อง ให้ AI ไปอ่านมาตอบเราหรือลูกค้าได้แบบเป๊ะ โดยการทำงานของระบบมีดังนี้

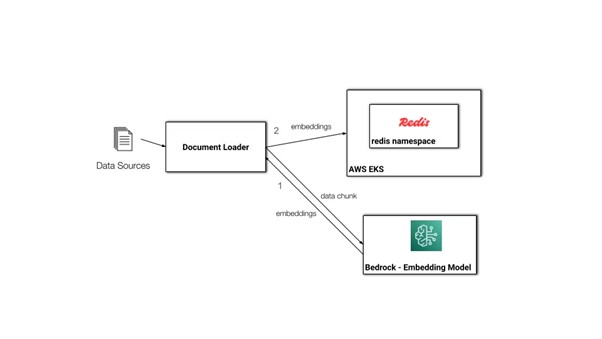

ภาพจาก : https://konghq.com/blog/engineering/rag-application-kong-ai-gateway-3-8

ในระบบนี้จะมีการแบ่งการทำงานออกเป็นสองช่วงหลัก ๆ ช่วงแรกคือ Data Preparation เป็นขั้นตอน เตรียมข้อมูลให้ AI เข้าใจ โดยเริ่มจากการโหลดเอกสารต้นฉบับที่องค์กรมีอยู่ ไม่ว่าจะเป็นบทสัมภาษณ์ เอกสารความรู้ คู่มือหรือแม้แต่บทความ แล้วเราก็เอาเนื้อหาเหล่านั้นมาตัดออกเป็นชิ้นเล็ก ๆ หรือที่เรียกว่า chunk เพราะว่าเราจะไม่ทำการ Embedding เป็นไฟล์ใหญ่ ๆ ต้องทำให้เป็นไฟล์เล็ก ๆ ก่อน เพื่อให้ง่ายต่อการประมวลผล หลังจากนั้นแต่ละ chunk จะถูกส่งต่อไปยัง Amazon Bedrock ซึ่งใช้โมเดลฝั่ง Embedding แปลงข้อความเหล่านี้ให้กลายเป็นเวกเตอร์หรือ embedding เพราะตอนที่ AI ประมวลผลคำเพื่อหาความคล้ายคลึงแล้วทำนายคำต่อ ๆ ไปมันจะต้องใช้ข้อมูลที่เป็นเวกเตอร์นี่แหละ พอเราได้ข้อมูลที่กลายเป็นเวกเตอร์ เราก็จะเอาทั้งหมดนี้ลงใน Redis ซึ่งทำหน้าที่เป็น Vector Database

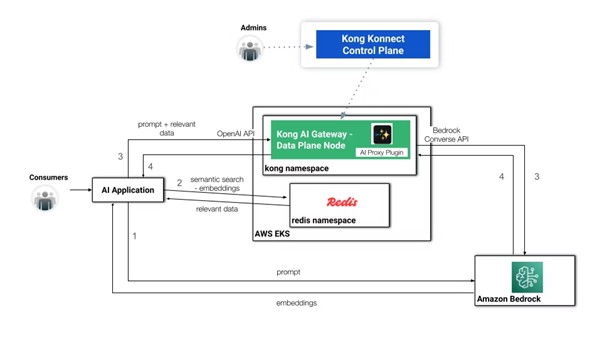

ภาพจาก : https://konghq.com/blog/engineering/rag-application-kong-ai-gateway-3-8

พอเราเตรียมข้อมูลเสร็จ ก็จะมีกระบวนการ Query Time ระบบจะเริ่มจากการแปลงคำถามนั้นให้กลายเป็น embedding ก่อน จากนั้นนำ embedding นี้ไปค้นหาใน Redis เพื่อหาข้อมูลหรือบริบทที่ใกล้เคียง เมื่อเจอข้อมูลที่เกี่ยวข้องแล้ว ระบบจะรวมคำถามของผู้ใช้เข้ากับบริบท แล้วส่งทั้งหมดนี้เข้าไปยัง Amazon Bedrock ผ่าน Kong AI Gateway เพื่อให้โมเดลสร้างคำตอบออกมา

ผลลัพธ์ที่ได้ก็คือคำตอบที่มีบริบทที่ชัดเจน โดยข้อมูลที่ตอบจะอ้างอิงจากเอกสารภายในจริง ไม่ใช่การเดาหรืออิงจากข้อมูลทั่วไปที่ LLM เคยเทรนมาเท่านั้น

จากที่เราได้รู้จัก Kong AI Gateway ไปแล้ว จะเห็นว่ามันช่วยให้เราสามารถทำระบบที่ลุยไปกับเทรนด์ของโลก AI ได้อย่างสบาย ๆ เชื่อมระบบของเรากับ AI เพิ่มประสิทธิภาพ เพิ่มความสามารถให้กับธุรกิจของเราได้แบบติดจรวด ไม่ต้องเขียนโค้ดเลย เหมาะมากสำหรับองค์กรที่พร้อมจะคว้าโอกาสใหม่ ๆ ที่ขับเคลื่อนไปในยุคของ AI

และถาคุณกำลังมองหาโซลูชันที่พร้อมใช้งานจริง ไม่ต้องเริ่มนับหนึ่งเองทั้งหมด Cloud HM ก็มีบริการที่ช่วยให้คุณติดตั้งและใช้งาน Kong AI Gateway ได้แบบครบวงจร ทีมผู้เชี่ยวชาญของ Cloud HM จะช่วยดูแลตั้งแต่การวางระบบ เชื่อมต่อ API ไปจนถึงการตั้งค่า AI Provider ต่าง ๆ ให้คุณใช้งานได้ทันที ไม่ต้องปวดหัวกับเรื่องเทคนิค ไม่ว่าจะเป็นองค์กรขนาดเล็กหรือใหญ่ Cloud HM ของเราก็พร้อมดูแล สนใจปรึกษาทีมผู้เชี่ยวชาญของเราได้ที่ https://www.cloudhm.co.th/th/contact-us/

Blog Home

Blog Home